Ambas posturas tienen sus pros y sus contras, y como todo en filosofía, seguramente esté completamente equivocado y la realidad sea algo intermedio o totalmente distinto. Sin embargo, como el estancamiento en un debate es algo que la Ciencia no se puede permitir, seguimos investigando, y hoy traigo un paper muy interesante.

En la década de los 50 del siglo pasado, Dimitri Belyaev, genetista del Instituto de Citología y Genética de la Academia Rusa de las Ciencias, empezó un curioso proyecto de cría de zorros en Novosibirsk, Siberia. Durante más de 60 años, el equipo de Belyaev, traspasado a Lyudmilla Trut tras la muerte de este en 1985, se dedicaron a seleccionar artificialmente a zorros de una granja peletera de acuerdo a su comportamiento. Del grupo original se seleccionaron solamente a los más tranquilos, y en posteriores generaciones se empezó a seleccionar a los que menos desconfiaban de los humanos. A partir de mediados de los 60 se empezó otro grupo de control negativo, en que los seleccionados eran los zorros agresivos. Después de solo medio siglo, los zorros de Belyaev socializan perfectamente, pese a ser todavía muy enérgicos y no tan cariñosos como un perro, y se venden como mascotas por la astronómica cifra de 9000€.

Esta información sorprenderá a muy poca gente, ya que estos zorros son una sensación en internet, y a todos nos gustaría tener uno, pero resulta que hace poco salió un estudio genético sobre ellos, y eso sí es una sorpresa. Todos los procesos de domesticación se llevaron a cabo hace cientos o miles de años, por lo que poder comparar la genética de grupos seleccionados activamente de una población salvaje es algo muy extraño.

Esta información sorprenderá a muy poca gente, ya que estos zorros son una sensación en internet, y a todos nos gustaría tener uno, pero resulta que hace poco salió un estudio genético sobre ellos, y eso sí es una sorpresa. Todos los procesos de domesticación se llevaron a cabo hace cientos o miles de años, por lo que poder comparar la genética de grupos seleccionados activamente de una población salvaje es algo muy extraño.

Una parte muy interesante de este estudio es que, como los zorros solo se han seleccionado teniendo en cuenta su comportamiento, en principio los cambios genéticos entre los diferentes grupos deberían estar asociados a dicha selección, y por lo tanto, a dicho comportamiento.

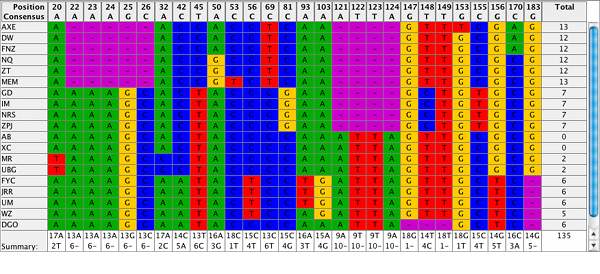

Y los resultados son bastante extraños. Lo primero que vemos es que, pese a que la selección se realizó solo para el comportamiento, ha habido cambios fisiológicos, morfológicos y reproductivos en los distintos grupos, lo que sugiere que los genes para los que estamos seleccionando hacen mucho más que modificar el comportamiento. Para ahondar en esta idea, resulta que el grupo de zorros domesticados tienen sobrerrepresentados genes para la estabilidad del ADN, o que los agresivos presentan una mayor expresión de interleucinas, lo que corroboraría estudios anteriores en que las ratas más agresivas tendrían una mejor respuesta inmunitaria que aquellas más tranquilas. Además, estos genes y sus receptores identificados en zorros domesticados también se han encontrado en perros cuando se comparó su genoma al de lobos salvajes.

Además de esta relación entre el desarrollo del comportamiento y otros factores fisiológicos, como cabría esperar, se ha encontrado una fuerte selección en genes relacionados con el desarrollo y la señalización en el tejido nervioso. El más prometedor de todos es el SorCS1, un gen que regula el tráfico intracelular de receptores de glutamato AMPA y neurexinas (ambos neurotransmisores), cuyas mutaciones se han asociado en bastantes estudios con desórdenes del comportamiento, como el autismo, problemas de aprendizaje, esquizofrenia, etc. Al comparar los genes de los zorros domesticados con aquellos característicos de desórdenes del espectro autista y el trastorno bipolar, se encontraron 22 coincidencias, muchos de ellos relacionados con la señalización del glutamato, algo que ya se había sugerido como característica de domesticación en perros, gatos y conejos.

Esto no es solo interesante desde un punto de vista genético o evolutivo, aunque es cierto que nos da una perspectiva fantástica de cómo funciona la domesticación, sino que nos ayuda a entender mejor qué efecto tienen los genes en las enfermedades mentales, algo que en humanos es bastante difícil de estudiar.

Todos estos resultados parecen sugerir que los determinista biológicos tienen razón, al menos en parte, y que de verdad hay una base biológica para nuestro comportamiento. Personalmente, creo que el enrocamiento clásico en estas posturas es inútil, y que lo más probable es que la realidad se acerque más a un modelo de "nature+nurture", en que nuestra biología sería el cajón de arena en que nuestras experiencias y nuestro entorno terminarían de dar forma a lo que somos. Un "yo mismo y mis circunstancias", que diría Gasset. Pero qué se yo, que solo soy un biólogo.